Транспьютерные системы – начало становления в России ЭВМ с массовым параллелизмом.

Галушкин Александр Иванович

Информация о первых транспьютерах появилась в начале 80-ых годов. Объективной причиной их появления явилась возможность на базе достигнутого уровня технологии микроэлектроники реализовать в одном кристалле 16-разрядный (а несколько позже 32-разрядный) микропроцессор, память и 4 канальных адаптера. Работа с первыми зарубежными образцами транспьютерных систем в период с 1987 по 1990 годы показала их эффективность и перспективность использования.

Для дальнейшего развертывания сферы применения транспьютерных систем, начиная с 1990г. была поставлена работа по созданию совместно с Координационным центром по информатике и вычислительной технике Болгарской Академии наук по созданию и поставкам российским предприятиям транспьютерных систем следующих типов:

- транспьютерный АРМ;

- транспьютерный АРМ средней производительности;

- транспьютерный АРМ высокой производительности;

- транспьютерный АРМ сверхвысокой производительности;

- транспьютерная графическая станция;

- транспьютерная система обработки изображений;

- транспьютерный АРМ с дисковой подсистемой.

В целом было поставлено в период с 1991 по 1992 гг. более 150 транспьютерных систем.

В докладе представлена краткая характеристика данных систем.

О транспьютерных системах

Под ЭВМ с массовым параллелизмом в отличие от классических многопроцессорных ЭВМ с числом процессоров 2, 4, 8, 16 (как правило не более) понимают ЭВМ с числом процессоров 4, 8, 10, 16, 32, 128, 256, 512, 1024 и более, в которых соблюдается принцип линейного (или почти линейного) роста производительности в зависимости от числа процессоров (физического объема или стоимости). Появление таких ЭВМ связано с разработкой в начале 80-х годов английской фирмой Inmos транспьютера T414. В отличие от обычных микропроцессоров транспьютере на кристалле (рис.1) были реализованы:

- 32-х разрядный микропроцессор;

- внутрикристалльное ОЗУ объемом 2 Кбайт;

- четыре канальных адаптера.

Для разработки следующей версии транспьютера T800 (рис. 2) фирме Inmos понадобилось около пяти лет. В него были введены два блока:

- блок выполнения операций с плавающей запятой;

- внутрикристалльное ОЗУ объемом 4 Кбайт;

Преимуществами транспьютерной идеологии построения сверхвысокопроизводительных ЭВМ были также развитое программное обеспечение, система интерфейсных СБИС (канальные, графические, ввода изображений и др.), система проблемно-ориентированных СБИС (обработка сигналов, изображений, дисковые системы, реализация тригонометрических функций и т.п.). Интерфейсные и проблемно-ориентированные транспьютерные СБИС имели, как и транспьютеры, свойство каскадируемости с использованием стандартных каналов связи.

Транспьютерные системы общего назначения

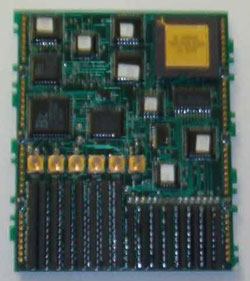

Наиболее распространенный вариант транспьютерной системы, позволявшей в те годы построить суперЭВМ из обычной ПЭВМ 286 представляет собой интерфейсную плату (фото 1) и материнскую плату (рис. 3 и фото 2) с возможностью установки на нее транспьютерных модулей размера 1 (фото 3) до 8 штук; размера 2 до 4 штук и размера 4 до 2 штук (фото 4) в любой комбинации. Причем пиковая производительность максимальной конфигурации такой системы была равна 1,5 MFLOPS или 90 MIPS при достаточно малой производительности ПЭВМ. Уже в то время говорилось, что транспьютерные системы имеют универсальное применение для задач, допускающих распараллеливание алгоритмов. В составе транспьютерного рабочего места поставлялись системы программирования на следующих языках:

- Occam 2 (оригинальная среда TDS или среда MS-DOS);

- Parallel C; (среда MS-DOS)

- Parallel Fortran;(среда MS-DOS)

- Parallel Pascal;(среда MS-DOS)

- LISP, Prolog;(среда MS-DOS)

- С, Fortran, Pascal, Modula-2 в среде ОС Helios (аналог Unix V);

- Ассемблер транспьютера.

Рис.1. Архитектура транспьютера T414

Рис. 2. Архитектура транспьютера T800

Рис. 3. Архитектура транспьютерного рабочего места с материнской транспьютерной платой и возможностью установки дочерних транспьютерных модулей

Фото 1. Интерфейсная транспьютерная плата

Фото 2. Материнская транспьютерная плата

Фото 3. Транспьютерный модуль размером 1

Фото 4. Транспьютерные модули размером 2 и 4

Рис. 4. Архитектура транспьютерного рабочего места средней производительности

На рис. 4 представлена схема транспьютерного рабочего места средней производительности, содержащего две платы – интерфейсную с одним транспьютером и базовую с четырьмя транспьютерами (фото 5). Пиковая производительность такой системы составляет 7,5 MFLOPS или 50 MIPS.

Фото 5. Транспьютерная плата с четырьмя транспьютерами

Рис 5. Архитектура транспьютерного рабочего места с одной или несколькими десятитранспьютерными платами

Фото 6. Транспьютерная плата с десятью транспьютерами

На рис. 5 представлена одна из наиболее популярных на период начала 90-ых годов поставляемых конфигураций – транспьютерное рабочее место с интерфейсной транспьютерной платой и одной или несколькими платами, на каждой из которых размещалось 10 транспьютеров (фото 6) с локальной памятью 1 Мбайт. Разработчик мог иметь на столе рабочую станцию в несколько десятков транспьютеров. Для случая одной 10-транспьютерной платы производительность такого рабочего места достигала 16,5 MFLOPS или 110 MIPS. При этом необходимо отметить, что производительность наиболее массовых тогда ЭВМ серии ЕС достигала всего нескольких MFLOPS, а ЭВМ представляла собой сооружение из нескольких стоек, занимавших помещение значительной (несколько десятков квадратных метров) площади.

Отметим, что состав программного обеспечения, указанный выше для простейшей транспьютерной системы, сохранялся и для других перечисленных конфигураций.

Специализированные транспьютерные системы

Характерной положительной особенностью транспьютерных систем, в настоящее время слабо реализуемой в современных кластерных суперЭВМ являлась возможность реализации специализированных под классы задач архитектур.

К ним относились:

- транспьютерные графические станции;

- транспьютерные системы обработки изображений;

- транспьютерные системы обработки сигналов;

- транспьютерные дисковые подсистемы.

Графические станции

Рис. 6. Транспьютерная графическая станция

На рис. 6 представлена архитектура транспьютерной графической станции, в которой реализовались:

- программируемая топология;

- шкалируемая производительность;

- разрешение 1280 x 1024 и выше;

- цветовая палитра до 16106 оттенков (8, 18, 24 бита на пиксель);

- 25-30 кадров в секунду.

В состав программируемого обеспечения транспьютерной графической станции входили следующие системы:

- ГРАФИЧЕСКИЕ БИБЛИОТЕКИ И СИСТЕМЫ для языков Parallel C, Parallel Fortran, Parallel Pascal;

- Сервер для работы с MS Windows;

- Система X-Window (ОС HELIOS).

Основные области применения подобных станций:

- графические системы реального времени: тренажеры, томография, системы виртуальной действительности;

- системы моделирования объектов, сред, процессов;

- различные САПР;

- научная визуализация:

- молекулярное моделирование,

- вычислительная гидродинамика;

- синтез реалистичных изображений, реклама, компьютерное кино.

Фото 7. Транспьютерный модуль графического адаптера

Транспьютерные системы обработки сигналов

Рис. 7. Структурная схема специализированного транспьютера обработки сигналов JMS A100

Рис. 8. Схема транспьютерного рабочего места обработки сигналов

Рис. 9. Схема специализированной транспьютерной платы обработки сигналов

Фото 8. Специализированная транспьютерная плата обработки сигналов

Фото 9. Транспьютерные модули АЦП и ЦАП сигналов

Принципиально важными и достаточно широко используемыми в начале 90-ых годов прошлого столетия были специализированные транспьютерные рабочие станции обработки сигналов. Основу таких систем составлял специализированный транспьютер обработки сигналов IMS A100, схема которого представлена на рис. 7. Подобная аппаратная реализация каскадируемого Z-фильтра с перестраиваемой разрядностью весовых коэффициентов, с нашей точки зрения представляет значительный интерес в настоящее время и в будущем с использованием текущей технологии микроэлектроники. На рис. 8, 9 представлены схема транспьютерного рабочего места обработки сигналов и схема платы APS-PC-DSP на базе сигнальных процессоров IMS A100 (фото 8). Отметим, что транспьютерное рабочее место обработки сигналов могло содержать несколько каскадируемых плат APS-PC-DSP. При наличии в рабочем месте только одной такой платы:

- производительность по обработке сигналов 1280 MOPS;

- максимальная скорость подачи входных сигналов до 10 Msamples/sec;

- производительность транспьютерной сети 4,5 MFLOPS 30 MIPS

- при закупке двух дополнительных TRAM, 7,5 MFLOPS 50 MIPS

- при закупке 8 TRAM размера 1, 13,5 MFLOPS 90 MIPS

Программирование в рабочем месте осуществлялось на языке Occam2 в среде TDS с помощью базовой системы DSP DS.

Были представлены пять примеров готовых программ по обработке сигналов.

Области применения:

- анализ сигнала, синтез формы сигнала;

- радарные, сонарные установки небольшой мощности;

- обработка, сжатие изображений, телевидение;

- обработка документов, сортировка писем, проверка багажа;

- распознавание рукописных и печатных символов;

- другие применения.

Транспьютерные системы обработки изображений

Рис. 10. Транспьютерная система обработки изображений

Фото 10. Транспьютерный модуль ввода изображений

На рис. 10 представлена схема транспьютерной системы обработки изображений. На материнской плате размещается специальный транспьютерный модуль ввода изображений (фото 10).

Основными характеристиками транспьютерной системы обработки изображений являлись следующие:

- программируемая топология;

- шкалируемая производительность;

- разрешение 1024 x 1024;

- обработка изображений в реальном масштабе времени;

- «серые» и цветные изображения;

- высокие показатели «производительность/стоимость».

В составе системы поставлялись следующие программные средства:

- библиотеки функций обработки изображений IPLIB, IPAL для языков Parallel C, Occam 2, Parallel Fortran;

- управление конфигурацией TINY router, GENESIS program.

Данная система имела следующие области применения:

- системы технического зрения;

- промышленная автоматика;

- роботы;

- медицина, биология, металлургия и др.: анализ и обработка изображений;

- спутниковые системы наблюдения: экология, картографирование и др.

Более совершенная по сравнению с представленной на рис. 10 транспьютерная система обработки изображений имела в своем составе специализированные платы на базе СБИС IMS A110. На рис. 11, 12 представлены структурные схемы платы и СБИС IMS A110.

Рис. 11. Структурная схема транспьютерной платы обработки изображений на базе СБИС IMS A110

Рис. 12. Структурная схема СБИС IMS A110 – специализированного транспьютера обработки изображений

Дисковые подсистемы

Именно транспьютерные системы стали предвестником современных дисковых систем, реализующих RAID-массивы. Еще в начале 90-х годов прошлого столетия в России поставлялись дисковые транспьютерные системы, структура которых представлена на рис. 13. На фото 11 показана транспьютерная плата, реализующая интерфейс дисковой системы.

Рис. 13. Структурная схема дисковой транспьютерной системы

Фото 11. Транспьютерная плата, реализующая интерфейс дисковой системы

Основные характеристики подобной дисковой системы были в то время следующими:

- производительность транспьютерной сети при установке 8 TRAM с T800 12 MFLOPS, 80 MIPS;

- интерфейс с шиной HOST-ПЭВМ (скорость обмена 200-300 Кбайт/сек). Интерфейс с драйверами жестких и гибких магнитных дисков (до 4 дисков);

- емкость одного диска – 80 Мбайт.

Имелись в наличии следующие программные средства управления дисковыми операциями:

- TBIOS (Transputer BIOS) – библиотека процедур доступа к дисковым операциям M212 для языка программирования Occam;

- TDOS – программная оболочка доступа к дисковым операциям M212 для системы программирования TDS;

- высокоуровневые файловые операции (типа open, read, write, close) для языков параллельного программирования (3L): C, Pascal, Fortran, обеспечивающие быстрый доступ к дисковым файлам через транспьютерные линки.

Транспьютерные рабочие станции сверхвысокой производительности

Верхним уровнем коммерческих поставок транспьютерных систем в начале 90-х годов прошлого столетия были транспьютерные рабочие станции сверхвысокой производительности, схема которых представлена на рис. 14, а общий вид – на фото 12.

Рис. 14. Общая схема транспьютерной рабочей станции сверхвысокой производительности

Фото 12 Общий вид транспьютерной рабочей станции сверх высокой производительности.

Данный вариант рабочей станции состоял из пользовательской ПЭВМ, интерфейсных транспьютерных плат, массива транспьютеров с коммутационной системой, подсистемы обработки сигналов и дисковой подсистемы. Общая производительность рабочей станции определялась следующим образом:

- Производительность транспьютерной сети

- 48 MFLOPS

- 320 MIPS

- Производительность по обработке сигналов

- 2560 MFLOPS

- Объем дисковой подсистемы – 320 Мб

Данные транспьютерные рабочие станции могли поставляться в любой комбинации специализированных транспьютерных подсистем.

Наряду с рассмотренной выше сверхвысокопроизводительной станцией на базе транспьютеров Т800 (Т805) предметом разработки и поставки в начале 90-х годов была сверхвысокопроизводительная рабочая станция на базе транспьютеров и процессоров i860. На рис. 15 представлена общая схема такой рабочей станции, а на фото 13 общий вид базовой платы с транспьютером и векторным процессором i860, суммарная пиковая производительность такой станции составляла 320MFLOPS. В составе рабочей станции поставлялось следующее программное обеспечение:

- PCi860-AL – пакет интерфейса стандартного ДОС к системе ТТМ100 включает компилятор языка С для i860;

- PCi860-C – компилятор языка С для i860;

- PCi860-F – компилятор языка ANSI FORTRAN 77 для i860;

- PCi860-M – пакет для управления из ПК неоднородной сетью процессоров IMST805 и i860 включая Inmos ANSI с Toolset IMSD7214;

- PCi860-D – символический отладчик для i860 на уровне командной строки;

- Арифметические библиотеки для i860

- i860lib-MA – математическая библиотека векторной обработки, включающая 260 функций

- i860lib – IPLIB – библиотека функций обработки образов по стандарту NEL

Необходимо отметить российскую разработку сверхвысокопроизводительной рабочей станции на базе транспьютерной платы в конструктиве «Эльбрус», содержащей 32 транспьютерных модуля с транспьютерами Т800 (Т805) и объемом памяти 1-4 Мбайта (фото 14).

Транспьютерные модули на плате размещались с двух сторон платы по 16 модулей с каждой стороны. Пиковая производительность одной платы достигала 320MIPS , а блок в составе 8 плат имел пиковую производительность 2560MIPS. В начале 90-х годов вычислительная система в несколько миллиардов операций в секунду, да еще в виде настольного блока была уникальной.

Рис. 15. Общая структура сверхвысокопроизводительной рабочей станции на базе транспьютеров и векторных процессоров i860

Фото 13. Транспьютерная плата с векторным процессором i860

Фото 14. Общий вид отечественной транспьютерной платы (32 транспьютерных модуля)

Транспьютерные системы на базе транспьютера T9000

В середине 90-х годов фирма Inmos, испытывая материальные и технологические трудности в разработке следующего поколения транспьютеров, вошла в консорциум Томсон CSF (Франция) и стала изготавливать перспективные транспьютеры на заводе в Гренобле, где по всей видимости, имелись большие технологические возможности по сравнению с прежним производством в г. Бристоль (Англия).

Очередное поколение транспьютеров представлял транспьютер T9000 (рис. 16), образцы которого с малой (25 МГц) тактовой частотой работы были изготовлены. На основе этих транспьютеров было создано некоторое количество высокопроизводительных систем, однако фирме Томсон CSF так и не удалось разработать образцы транспьютера T9000 с более высокой тактовой частотой и большой скоростью передачи информации по каналам связи между транспьютерами. Было изготовлено небольшое количество образцов систем на базе транспьютера T9000 (фото 15), которые так и не пошли в серийное производство.

Транспьютеры в течении многих лет являлись основой построения сверхвысокопроизводительных ЭВМ во многих странах мира: Англии, Германии, Франции, США, Японии, Китае, России, Болгарии и др.

Однако за последние годы структура рынка транспьютеров изменилась вследствие конкурентной борьбы было целостное подавление европейской инициативы по ликвидации монополии США в области суперЭВМ. Для этого в конце 80-х годов США была развернута разработка по крайней мере трех эффективных транспьютероподобных элементов для ЭВМ с массовым параллелизмом. TMS32C40 (C60, C80), SHARK и «Neuron», по архитектуре близких к транспьютерам и выполняющих практически те же функции, но обладающих большими возможностями.

Рис. 16.Общая структура транспьютера T9000

Фото 15. Общий вид транспьютерной системы на базе транспьютера T9000.

Заключение

Необходимо отметить, что транспьютеры фактически явились во всем мире, в том числе и в России, началом становления ЭВМ с массовым параллелизмом. Современная кластерная суперЭВМ отличаются от транспьютерных систем лишь типом процессоров, объемом памяти и некоторым деталям архитектурных построений.

Еще в начале 90-х годов уникальные транспьютерные системы состояли из нескольких сотен транспьютерных узлов и по тем временам представляли собой самые мощные суперЭВМ по критерию отношения производительности к стоимости (или объему оборудования). Необходимо также отметить, что транспьютерные системы были в то время наиболее эффективными программно-аппаратными эмуляторами-ускорителями нейросетевых алгоритмов решения различных задач.

Литература

- Галушкин А.И., Грачев Л.С., Точенов В.А. Алгоритмы реконфигурации в многомикропроцессорных системах. «Кибернетика» АН УССР, №2, 1990 г.

- Транспьютерные ЭВМ. (колл. авторов). Издательство НИИ «Квант», 1990 г.

- Галушкин А.И., Елизаров Г.С., Точенов В.А., Хачатурян К.К. Справочник по транспьютерным системам, Изд-во МАИ, 1990 г.

- Galushkin A.I. The Architectures of Neural Computers, Joint British-Soviet Workshop on transputer systems. Moscow, 26-29 June, 1990.

- Galushkin A.I. The Neural Computers on the Base of transputers and Signal processing. Moscow, 26-29 June, 1990.

- Galushkin A.I., Tochenov V.A. and all. The pattern recognition systems with variable structure on the base of personal computer and transputer system. Joint British-Soviet Workshop on transputer systems, Moscow, 26-29 June, 1990.

- Galushkin A.I., Kuzmin L.A. and all. The organization studing and improvement of professional skill of transputer system. Joint British-Soviet Workshop on transputer systems, Moscow, 26-29 June, 1990.

- Алеутдинов М.А., Галушкин А.И., Медовый В.С. Система цитологических изображений на базе транспьютеров. Вторая Всероссийская конференция «Транспьютерные системы и их применение», 1992 г.

- Galushkin A.I., Grachev L.V., Kravchenko V.V. A transputer network-based general purpose neurocomputer. Int. Join Conference on Neural Networks, Nagosa, Japan 25 Oct., 1993.

- Кузьмин Л.А. Курс лекций по языку OKKAM-2. НИИ «Квант», М, 1994 г.

- Галушкин А.И. Нейрокомпьютеры, М., ИПРЖР, 2000 г.

- Галушкин А.И. Некоторые исторические аспекты развития элементной базы вычислительных систем с массовым параллелизмом (80-е – 90-е годы), «Нейрокомпьютер», №1, 2000 г. (67-82)

Об авторе: НИИ автоматической аппаратуры Научный центр нейроком, neurocomputer@yandex.ru

Материалы международной конференции SORUCOM 2006 (3—7 июля 2006 года)

Статья помещена в музей 22.07.2008 с разрешения автора